- Новости науки и техники

- Информационные технологии

04 июля 2025, 21:40

Китайские ученые разработали технологию защиты блокчейна от квантовых взломов

Технология блокчейна, или распределенного цифрового хранилища данных, хранящего защищенные от несанкционированного доступа записи, готовится совершить революцию в финансовом секторе, инвестициях, логистике и в других областях. Однако квантовые компьютеры грозятся сделать современные методы шифрования бесполезными. Новый метод, предложенный китайскими учеными, обещает уберечь блокчейн от квантового взлома.

Читать ещё

04 июля 2025, 14:29

Когда аналитика становится понятной: Александр Полянкин о взаимодействии с большими данными

В мире, все больше управляемом данными, способность быстро и интуитивно извлекать значимые инсайты стала конкурентным преимуществом. Александр Полянкин, ведущий разработчик Metabase, раздвигает границы возможного в бизнес-аналитике, разрабатывая инновационные решения на базе искусственного интеллекта, которые позволяют нетехническим пользователям делать сложные запросы к базам данных с помощью естественного языка. От его начала пути в программировании с мечтами о разработке игр до архитектуры си

Читать ещё

Фотонные процессоры на кристалле стали инновационным решением для быстрого выполнения задач машинного обучения благодаря сверхнизкому энергопотреблению. Однако повышение вычислительной плотности таких систем остается серьезной проблемой, в первую очередь из-за трудностей миниатюризации и интеграции ключевых компонентов оптической интерференции. Команда ученых из США и Китая смогла решить эту проблему и представила метод производства сверхкомпактных фотонных процессоров площадью всего 64 мкм², чт

Читать ещё

21 июня 2025, 00:00

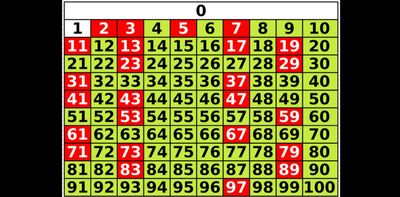

Обнаружена скрытая закономерность в последовательности простых чисел - New-Science.ru

Профессор Кен Оно из Университета Вирджинии совершил открытие, способное изменить математическое пон

Читать ещё

20 июня 2025, 10:49

Как работают облака: от аренды серверов до искусственного интеллекта

Сегодня в облаке запускают продукты, тестируют гипотезы, обучают ИИ-модели, автоматизируют бухгалтерию и разворачивают сервисы и приложения на сотни тысяч пользователей. Когда мы говорим, что бизнес «уходит в облако», мы имеем в виду не красивую метафору, а вполне конкретную практику — аренду инфраструктуры, вычислительных мощностей и приложений у провайдера, который отвечает за их надежную работу.

Читать ещё

20 июня 2025, 10:49

Как сервисы доставки, интернет-магазины, банки и онлайн-кинотеатры зависят от облака

Онлайн-шопинг, доставка еды, мобильный банкинг и стриминг кино — часть повседневности. Мы почти не задумываемся, что делает все это возможным. Ответ — облачные технологии. За каждой покупкой, переводом или просмотром фильма работает невидимая инфраструктура, без которой современные цифровые сервисы попросту остановились бы. Рассказываем, как облака изменили нашу цифровую жизнь и стали незаметным мотором современной экономики.

Читать ещё

17 июня 2025, 00:00

Умные часы могут стать следующей угрозой для шпионажа: новое исследование показывает, как они могут обойти системы с физической изоляцией - New-Science.ru

Исследователи из Университета Бен-Гуриона в Негеве (Израиль) продемонстрировали, как обычные умные ч

Читать ещё

13 июня 2025, 00:00

«Психоз, вызванный ChatGPT»: когда ИИ становится угрозой для психического здоровья - New-Science.ru

Во всем мире появляются свидетельства случаев почти патологической одержимости ChatGPT, приводящей к

Читать ещё

09 июня 2025, 13:35

Обзор HPE ProLiant MicroServer Gen10 Plus — компактный и мощный сервер для малого бизнеса

Подробный обзор сервера HPE ProLiant MicroServer Gen10 Plus: производительные процессоры, до 32 ГБ DDR4 памяти, поддержка RAID, удалённое управление iLO — идеальное решение для малого и среднего бизнеса

Читать ещё

02 июня 2025, 15:15

Наставник, секретарь и друг: OpenAI сделает из ChatGPT помощника на все случаи жизни

Представьте ИИ-ассистента, который не просто отвечает на вопросы, а понимает вас, помогает с делами, сопровождает дома, на работе и в дороге — и делает это так, будто рядом умный, надежный и чуткий человек. Согласно внутреннему документу OpenAI, компания в первой половине 2025 года начнет превращать ChatGPT в такого «суперпомощника». Чат-бот сможет выполнять сложные задачи, действ

Читать ещё